外观

喂饭式教程 - 腾讯云轻量服务器部署DeepSeek

前置条件

有 1 台 最低配置为 2 核 4G 的轻量应用服务器,理论上来说,服务器配置越高,效果越好。

一、选择镜像

新购或旧有系统重装,选择应用模板,再选择 DeepSeek-R1 1.5B 即可。

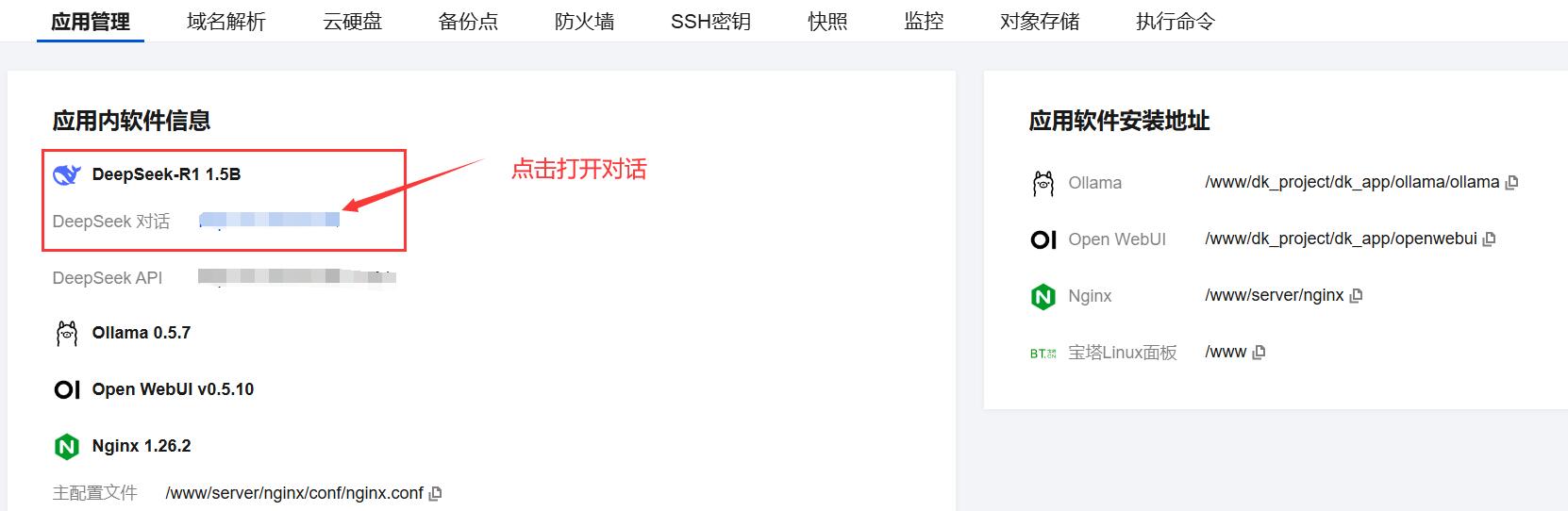

二、查看应用信息

系统安装完成后,在轻量应用服务器详细页面,可以查看应用信息及进行应用管理。

三、开始使用

默认自带的有 Open WebUI 界面,可以可视化的使用大模型。

若系统刚重装完毕,点击该网站有可能打不开,大概率是应用正在启动,稍后再试即可。

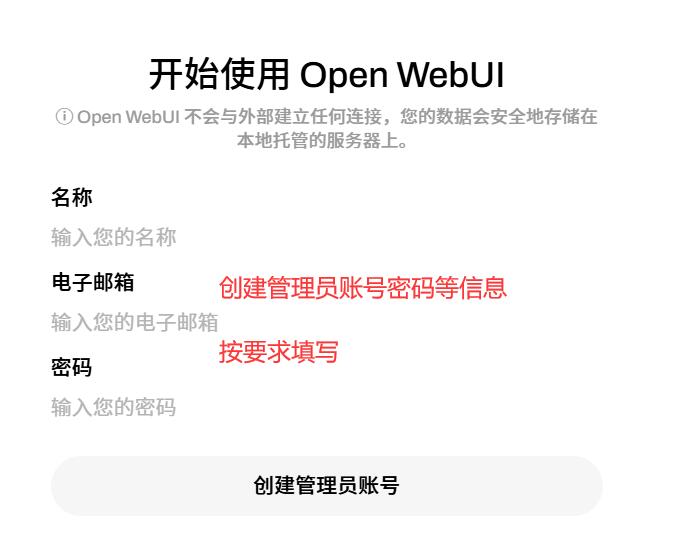

四、创建管理员账号

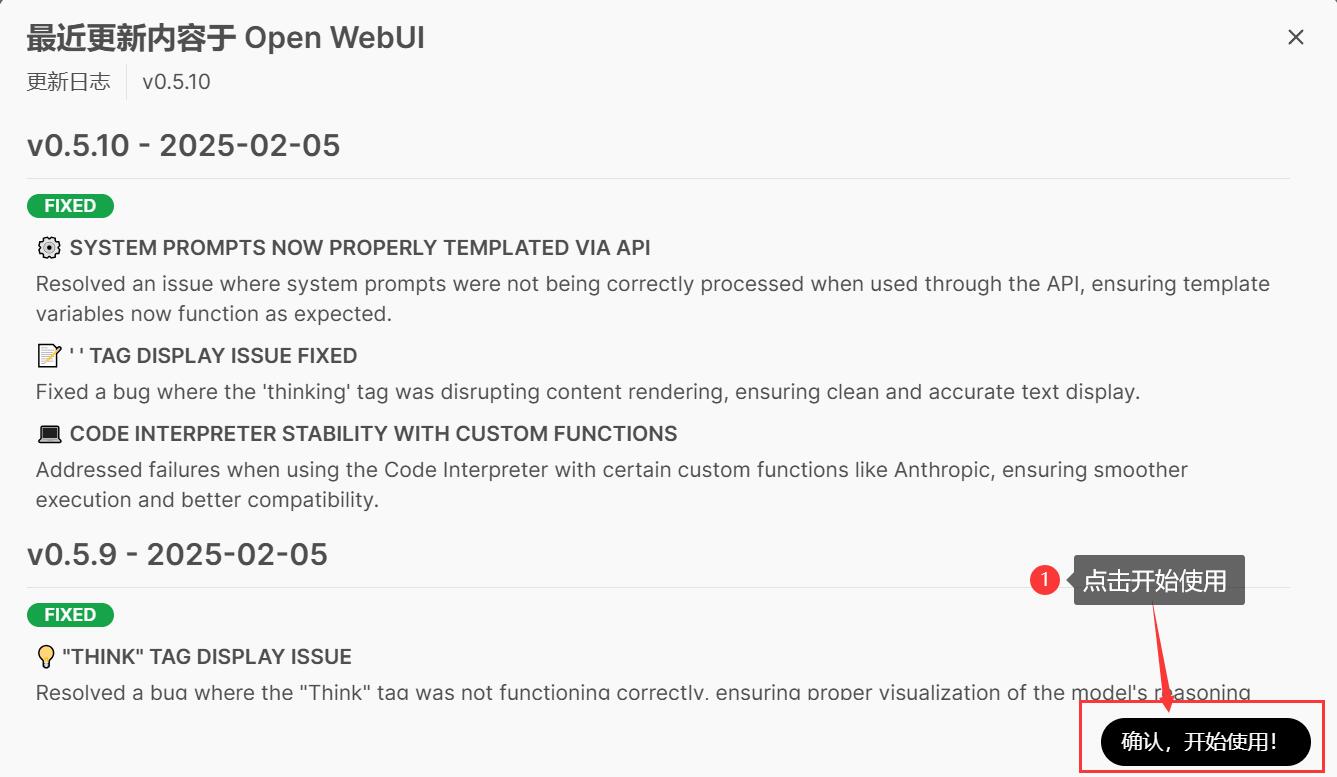

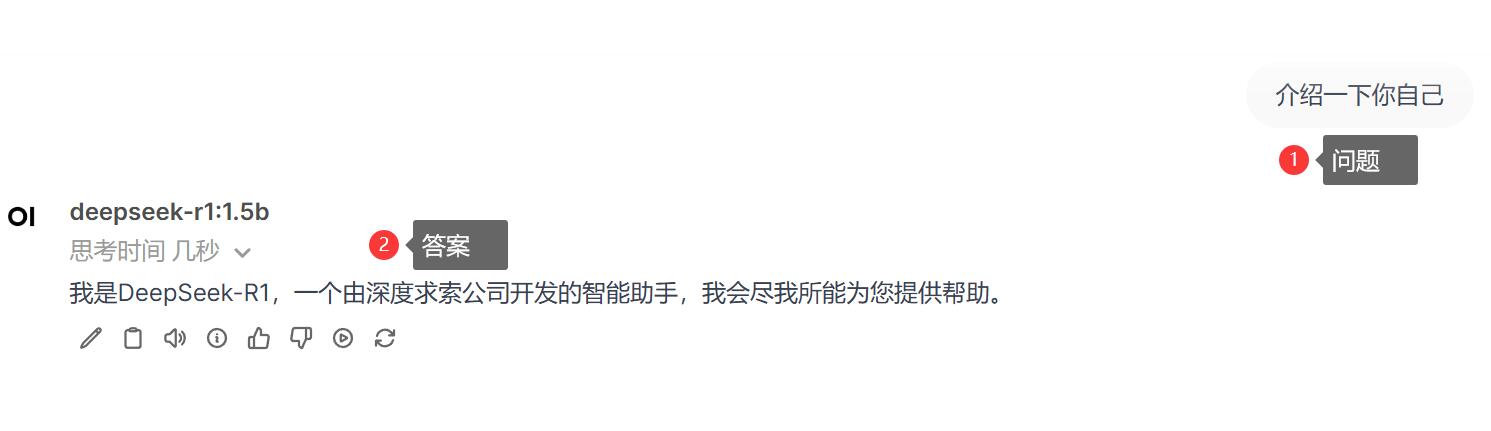

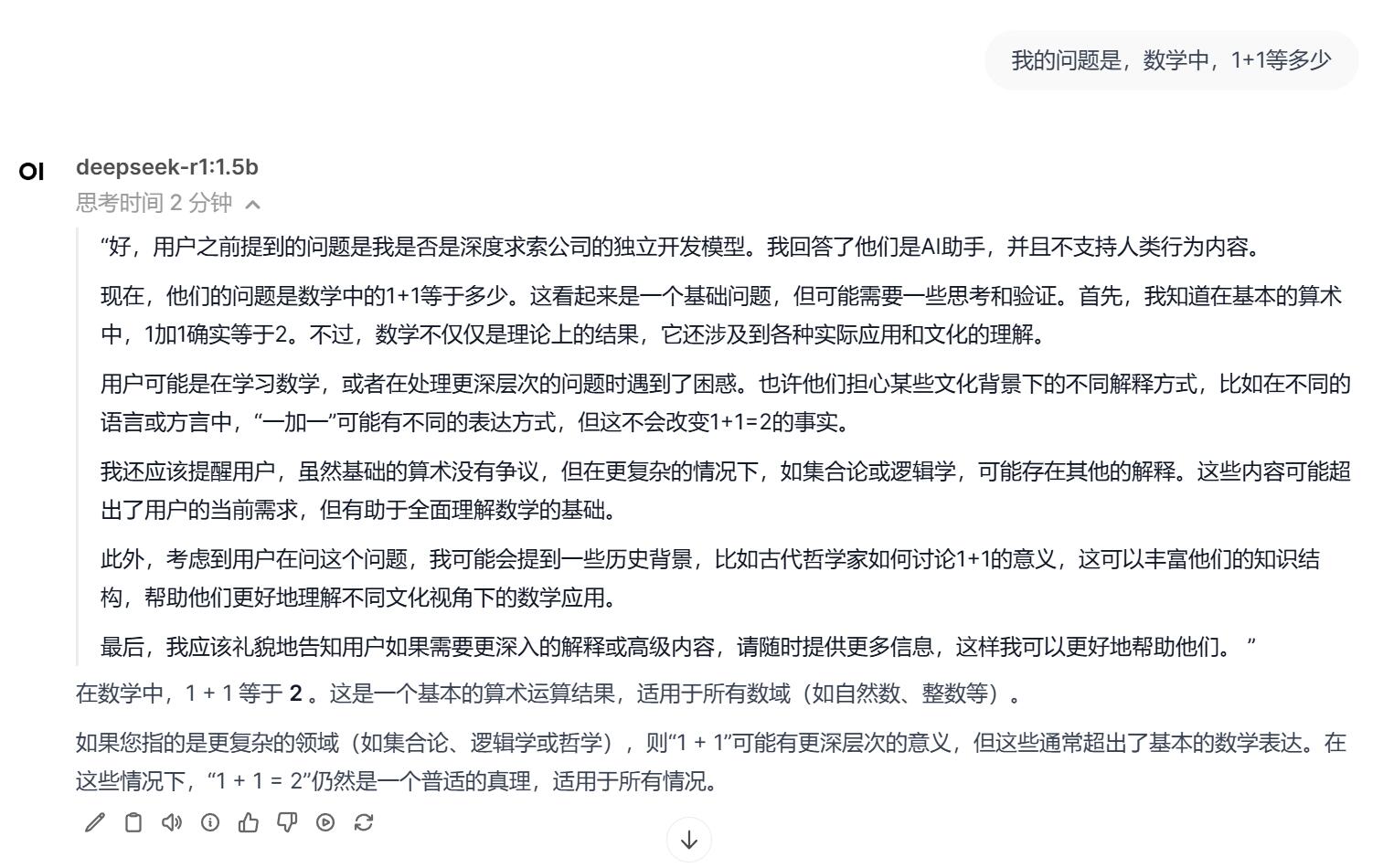

五、进行对话

至此私有化部署及设置 DeepSeek 已完成,可以进行对话。

不愧是 AI,想的就是多。

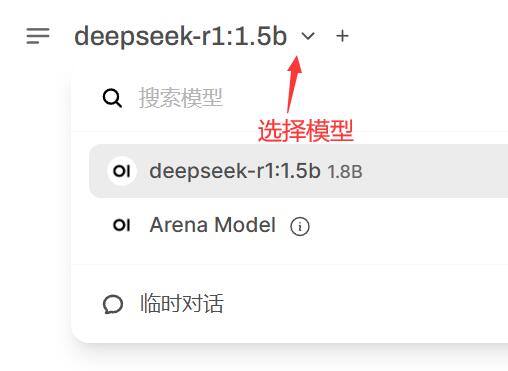

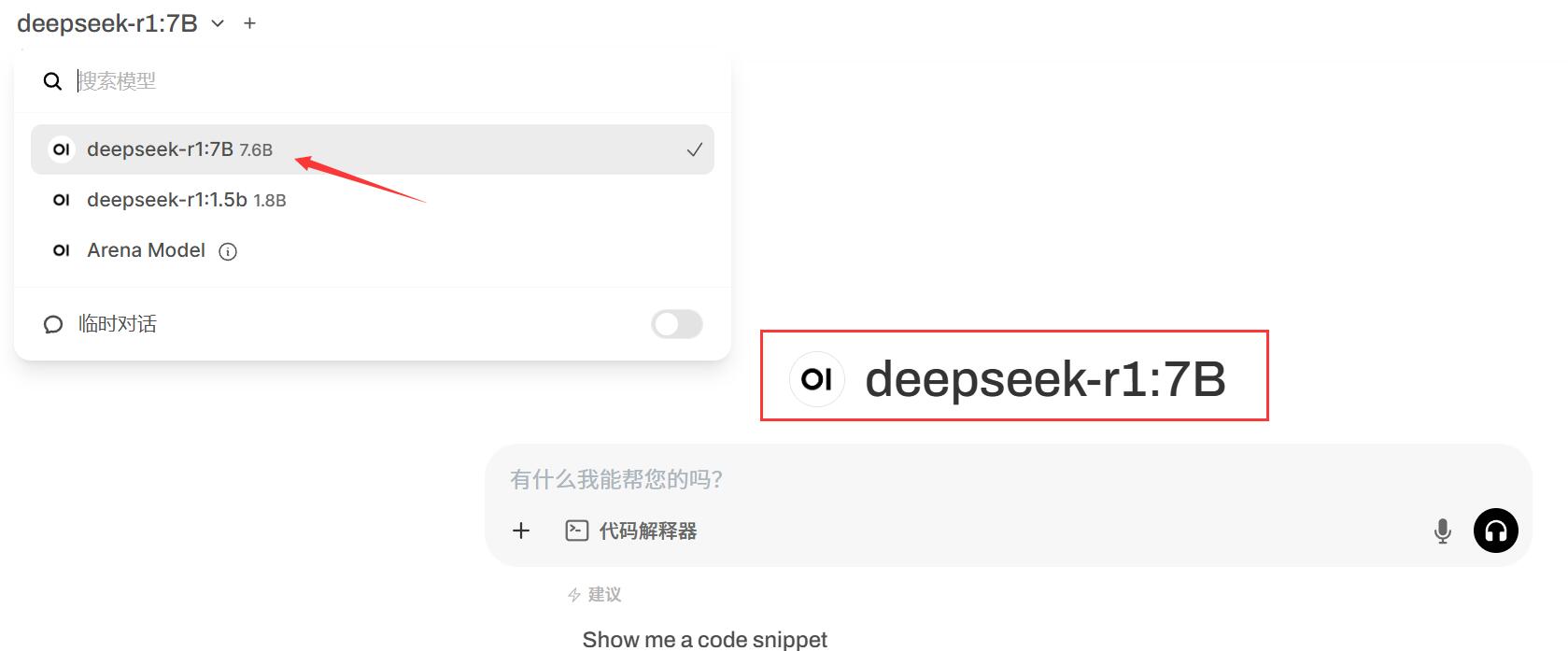

六、选择模型

系统默认已经完成 DeepSeek 1.5B 模型的安装,也可以添加模型。

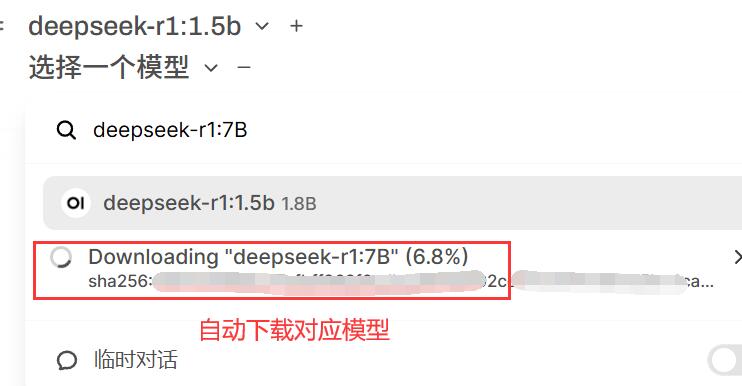

七、添加模型

DeepSeek-R1 就是深度搜索-R1 模型,包含 Distilled models 的是蒸馏模型。

| 模型 | 模型名 | 模型大小 |

|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | deepseek-r1:1.5b | 1.1G |

| DeepSeek-R1-Distill-Qwen-7B | deepseek-r1:7b | 4.7G |

| DeepSeek-R1-Distill-Llama-8B | deepseek-r1:8b | 4.9G |

| DeepSeek-R1-Distill-Qwen-14B | deepseek-r1:14b | 9.0G |

| DeepSeek-R1-Distill-Qwen-32B | deepseek-r1:32b | 20G |

| DeepSeek-R1-Distill-Llama-70B | deepseek-r1:70b | 43G |

| DeepSeek-R1 | deepseek-r1:671b | 404G |

具体详细信息以官网介绍为准。

如要安装模型 DeepSeek-R1-Distill-Qwen-7B ,则只需输入模型名 deepseek-r1:7b ,点击拉取后,系统会自动拉取模型进行下载,下载完成后,再选择模型即可。

下载通常需要较多的时间。

八、对话高级设置

点击右上角按钮可以进入高级设置,适合对 AI 模型有一定了解的用户配置。

选择什么样的模型

从表中可以看出,模型参数越大则文件体积越大,相应的对硬件要求也就越高。从运行结果来看,拥有更大参数量的模型(如 DeepSeek-R1)在推理效果上更胜一筹,但另一方面,更小参数的 Distilled models(蒸馏模型)模型的响应速度更快、占用资源更少、部署时长更短,在处理较为简单的任务时,仍是不错的选择。

具体选择要根据服务器硬件参数来决定,配置低的就选择低参数量,如要追求更好的推理结果,高参数量的模型也必须搭配高配置的服务器。

如果运行一个模型响应很卡顿,大概率说明服务器配置不够,可以考虑升级配置或降低模型参数量。